Künstliche Intelligenz KI (Artificial Intelligence - AI)

Künstliche Intelligenz (KI) - Artificial Inteligence (AI) strebt das Erreichen oder sogar Übertreffen der Intelligenz eines Menschen an. Dinge, die oft mit Intelligenz in Verbindung gebracht werden, wie etwa Rechnen, Schach spielen oder sich grosse Datenmengen merken, können vom Computer schneller und besser erledigt werden.

KI kann selbständig Aufgaben lösen, ohne speziell dafür programmiert zu werden.

KI wird mit jeder neuen Aufgabe besser.

KI-Systeme werden leistungsfähiger, sie werden in der Lage sein, mit Menschen zusammenzuarbeiten, um eine Vielzahl von Problemen zu lösen, die wir derzeit nicht lösen können.

Der Einsatz von KI nimmt rasant zu und es ist klar, dass diese Technologie das Potenzial hat, viele Aspekte unseres Lebens zu revolutionieren. Es muss sichergestellt werden, dass KI verantwortungsvoll und ethisch eingesetzt wird, damit sie der gesamten Menschheit zugute kommt.

KI hat die Art und Weise, wie wir Daten verarbeiten und nutzen, revolutioniert. Algorithmen für maschinelles Lernen können riesige Datensätze analysieren, verborgene Muster aufdecken und Vorhersagen mit bemerkenswerter Genauigkeit treffen. Im Geschäftskontext unterstützt KI alles, von personalisierten Kundenerlebnissen bis hin zur vorausschauenden Wartung, und macht den Betrieb effizienter und kostengünstiger.

Trotz jahrzehntelange Forschung steht aber die Entwicklung der KI noch relativ am Anfang. Damit sie in sensiblen Bereichen wie dem automatisierten Fahren oder der Medizin eingesetzt werden kann, muss sie zuverlässiger und sicherer gegen Manipulationen werden.

Aktuelle leistungsstarke Prozessoren und Grafikkarten in Computern, Smartphones und Tablets ermöglichen es normalen Verbrauchern auf KI-Programme zuzugreifen.

Immer mehr KI-generierte Inhalte (Texte, Bilder, Audio) landen im Internet, aber die Qualität dieser sinkt immer weiter (MAD-Krankheit). Es muss also gegengesteuert werden, um die KI nicht weiter degenerieren zu lassen.

Es gibt Bestrebungen die KI sicherer und verantwortungsvoller zu machen, so haben Microsoft, Anthropic, Google und OpenAI das Frontier Model Forum ins Leben gerufen, einen Branchenverband, der sich auf die Gewährleistung einer sicheren und verantwortungsvollen Entwicklung von Frontier-KI-Modellen konzentriert.

Mit LLMs und einer Technologie namens Diffusion AI können Systeme jetzt andere Fähigkeiten erreichen oder übertreffen, die wir oft mit Intelligenz assoziieren, wie zum Beispiel: Präzise auf Spracheingaben reagieren und neue Textinhalte erstellen, Schreiben origineller Geschichten und Gedichte, Analysieren von Inhalten auf Ton und Emotionen, Erstellen einzigartiger Bilder und Videos.

Trotz ihrer Fortschritte ist die KI aber nicht so gut wie der Mensch, wenn es um strategisches und kreatives Denken geht.

Es wird geschätzt, dass KI bis 2030 zwischen 10 und 15 Billionen $ zur Weltwirtschaft beitragen könnte. Es wird erwartet, dass der globale KI-Markt eine durchschnittlichen jährlichen Wachstumsrate von 36,2% ab 2022 haben wird.

Deutschland wird in KI 2024, 500 Millionen € investieren. Deutschland und Europa sollen in einer Welt "Powered by AI" eine Spitzenposition einnehmen und technologische KI-Souveränität erreichen. Das Bundesministerium für Bildung und Forschung (BMBF) betrachte die Bereitstellung von KI-Tools, KI-Kompetenzen und KI-Infrastruktur als Teil der Grundversorgung.

Fast jede Regierung, jedes große Unternehmen und jede Organisation auf der Welt arbeitet an einer KI-Strategie.

Wenn Unternehmen Innovationen mit KI der nächsten Generation einführen, stellen drei Kriterien den Erfolg sicher: technologische Machbarkeit, wirtschaftliche Machbarkeit und gesellschaftliche Werte. Zu den zukünftigen KI-Technologien gehören multimodale Systeme, KI-Rechtshilfe, humanoide Roboter und Forschungsunterstützung.

Meilensteine der KI Geschichte

Es wird behauptet, dass der Mechanismus zur Erzeugung von "Ars generalis ultima" (Die ultimative allgemeine Kunst), veröffentlicht von Ramon Llull im Jahr 1308, eine künstliche Intelligenz mit mechanischen Mitteln war, um aus Logik und Logik neues Wissen zu schaffen komplexe mechanische Techniken.

Im Jahr 1914 stellte der spanische Ingenieur Leonardo Torres y Quevedo in Paris die erste Schachspielmaschine vor, die in der Lage war, Informationen über eine Schachpartie zu empfangen und von jeder Position aus ohne menschliches Eingreifen ein König-Turm-Endspiel gegen den König zu spielen.

Norbert Wiener veröffentlichte das Buch "Cybernetics or Control and Communication in the Animal and the Machine" (1948), das großen Einfluss auf die Erforschung von KI und Steuerungssysteme hat.

Im Jahr 1950 veröffentlichte Alan Turing "Computing Machinery and Intelligence" und führte damit das Konzept des Nachahmungsspiels ein. Dies wurde später als Turing-Test bekannt, der die Fähigkeit einer Maschine testet, ein Verhalten zu zeigen und Ergebnisse zu erzeugen, die nicht von dem einer erwachsenen Person zu unterscheiden sind.

Alan Turing's Turing-Test (1950) ist ein berühmter Test, der die Frage stellte: "Können Maschinen denken?"

Der Programmierer John McCarthy schlägt 1956 den Begriff "Künstliche Intelligenz" vor.

Das robinsonische Auflösungsprinzip (1965) ermöglicht einen automatisierten Theorehmbeweis.

Die Jahre von 1956 bis 1974 gelten als Renaissance der künstlichen Intelligenz mit Entwicklungen wie semantischen Netzen, die es Maschinen ermöglichten, algebraische Wortprobleme zu lösen, und Suchalgorithmen, die es Maschinen ermöglichten, Probleme ähnlich wie ein Labyrinth zu lösen.

Ein Pionier der KI war der Multigenie Marvin Minsky.

"SHRDLU" war ein frühes Computerprogramm zum Verständnis natürlicher Sprache, das von Terry Winogradam (MIT) in den Jahren 1968–1970 entwickelt wurde.In dem Programm führt der Benutzer ein Gespräch mit dem Computer, bewegt Objekte, benennt Sammlungen und fragt den Status einer vereinfachten "Blockwelt" ab, im Wesentlichen einer virtuellen Box, die mit verschiedenen Blöcken gefüllt ist.

Mit "MYCIN" (1972) findet Künstliche Intelligenz den Weg in die Praxis: Das von Ted Shortliffe an der Stanford University entwickelte Expertensystem wird zur Behandlung von Krankheiteneingesetzt. Als Expertensystem wird ein Softwaresystem bezeichnet, wenn es in der Lage ist, Lösungen für Probleme aus einem begrenzten Fachgebiet (Wissensdomäne) zu liefern, die von der Qualität her denen eines menschlichen Experten vergleichbar sind oder diese sogar übertreffen. In der Medizin dienen sie zur Unterstützung bei Diagnose und Therapie.

KI erlebte zwischen 1974 und 2011 eine Flaute und einen Aufschwung, in dem die Rechenleistung und die Menge der verfügbaren Daten erhebliche Engpässe darstellten. In diese Periode wurden Agenten wie Deep Blue und AlphaGo entwickelt die in der Lage waren, mit den besten menschlichen Brettspielspielern der Welt mitzuhalten und diese sogar zu übertreffen.

KI-Kategorien

- Artificial Narrow Intelligence (ANI) oder schwache KI sind Systeme, die als die am wenigsten rechenleistungsstarke KI gelten. Diese Systeme umfassen viele der modernen Modelle des maschinellen Lernens und des Deep Learning mit einzelnen und eingeschränkten Funktionen wie Objektklassifizierung und Spracherkennung.

- Allgemeine Intelligenz (AGI) oder starke KI sind Systeme, die den Turing-Test bestehen würden, mit einer Intelligenz, die Ergebnisse erzeugt, die nicht von denen eines erwachsenen Menschen zu unterscheiden sind. Zum Zeitpunkt der Veröffentlichung wurde kein öffentlich bekanntes AGI entwickelt. Künstliche allgemeine Intelligenz (AGI) ermöglicht es Computern, flexibel wie Menschen zu lernen, zu handeln und zu denken. Trotz aller Fortschritte bleiben die heutigen KI-Systeme "schmal", was bedeutet, dass sie für bestimmte Aufgaben gut sind und für neue Dinge umprogrammiert werden müssen. AGI ermöglicht es Computern, flexibel wie Menschen zu lernen, zu handeln und zu denken. Trotz aller Fortschritte bleiben die heutigen KI-Systeme "schmal", was bedeutet, dass sie für bestimmte Aufgaben gut sind und für neue Dinge umprogrammiert werden müssen.

- Artificial Super-Intelligenz (ASI) oder Superintelligenz ist eine weitere noch zu entwickelnde Form der KI, die Intelligenz enthält, die Ergebnisse erzeugen kann, die die Kapazität eines Menschen bei weitem übertreffen würden.

Liste von KI-Tools

- ChatGPT

- Bard

- DALL-E 2

- Regenbogen-KI

- GuestLab

- Hommage

- Laxis

- Quillbot

- Midjourney

- Stable Diffusion

Liste von AI Software

- Google Cloud Machine Learning Engine (Maschinelles Lernen, Trainiert Modell anhand von Daten, Nicht kostenlos)

- Azure Machine Learning Studio (maschinelles Lernen, browserbasiert, Modell wird als Webdienst bereitgestellt, kostenlos)

- TensorFlow (Maschinelles Lernen, Desktops, Cluster, ist für alle vom Anfänger bis zum Experten, kostenlos)

- H2O AI (Machine Learning, Distributed In-Memory, Programmierung, Sprachen: R & Python, AutoML-Funktionalität enthalten, kostenlos)

- Cortana (Virtuelle Assistentin, alle Betriebssysteme, kostenlos) IBM Watson (Frage-Antwort-System, Linux, Es lernt viel aus kleinen Daten, kostenlos)

- Salesforce Einstein (CRM-System, cloudbasiert, keine Notwendigkeit für die Verwaltung von Modellen und die Datenvorbereitung)

- Infosys Nia (maschinelles Lernen, Chatbot, Betriebsysteme: Windows, Mac und webbasiert, bietet drei Komponenten, nämlich Datenplattform, Wissensplattform und Automatisierungsplattform)

- Amazon Alexa (Virtueller Assistent, Betriebssysteme: Fire OS, iOS und Android, IT kann mit Geräten wie Kamera, Lichtern und Unterhaltungssystemen verbunden werden, kostenlos mit einigen Amazon-Geräten oder -Diensten)

- Google Assistant (Virtueller Assistent, Betriebssystem: Android, iOS und KaiOS, unterstützt Zwei-Wege-Konversation, kostenlos)

- Dante AI (Dieser Chatbot basiert auf GPT-4, dem fortschrittlichsten Sprachmodell von OpenAI, das über 100 verschiedene Sprachen erkennen kann, was es inklusiv und sprachfreundlich macht, Es wird angeboten über den Amazon Web Services)

Microsoft's Webbrowser Bing benutzt KI und GPT-4.

DeepL ist ein KI-Dolmetscher für immer mehr Sprachen.

Microsoft unter Satya Nadella hat das Projekt OpenAI ins Leben gerufen.

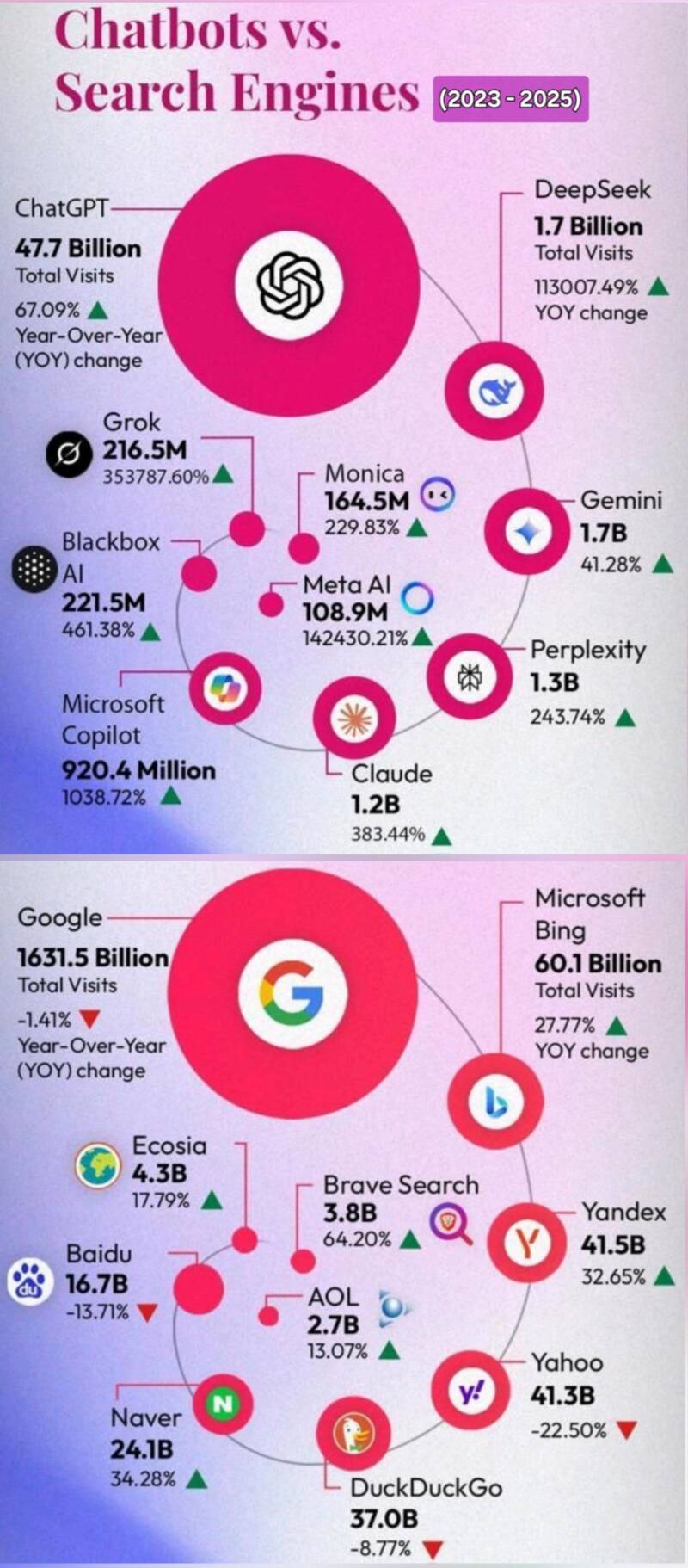

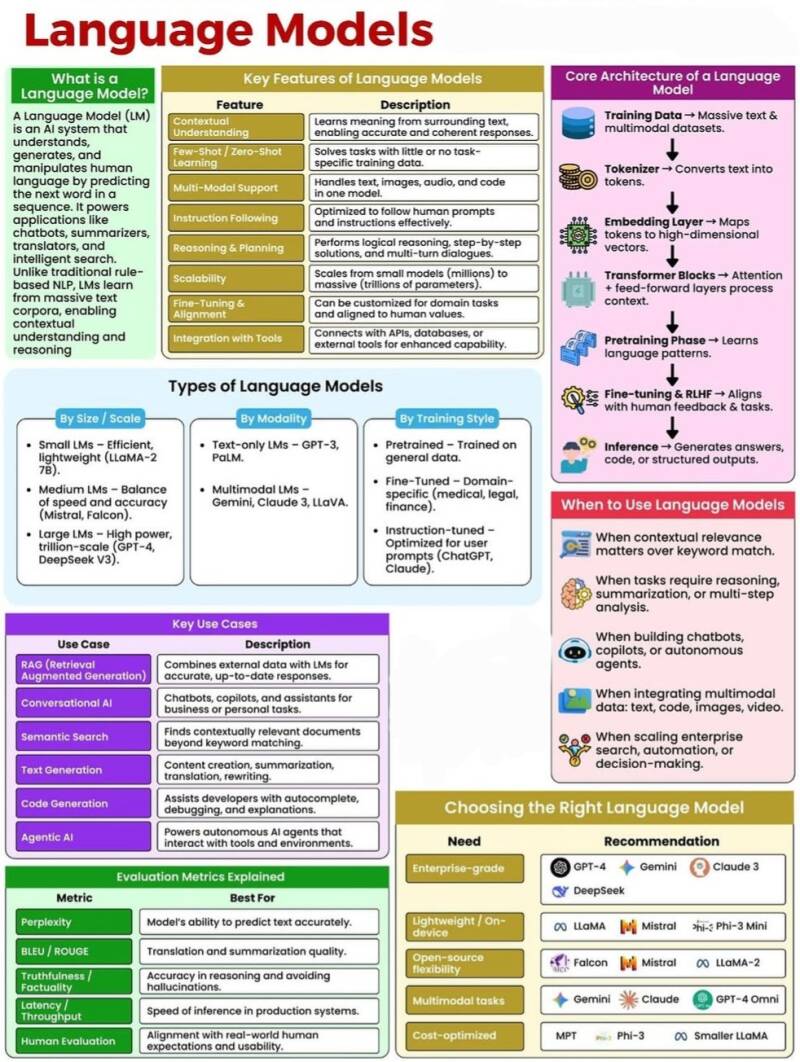

Large Language Models (LLMs) verändern das digitale Marketing. Google hat beispielsweise kürzlich die Integration von LLMs in seine Suchergebnisse als Reaktion auf den OpenAI/ChatGPT-basierten Bing Chat angekündigt.

Unter Generative AI versteht man die Verbindung von LLMs mit Technologien, die neben Textergebnissen auch digitale Inhalte wie Bilder, Videos, Musik oder Code generieren können. Es wird erforscht, über digitale Inhalte hinauszugehen und diese Technologie für so unterschiedliche Dinge wie die Entdeckung neuer Moleküle und 3D-Designs zu nutzen. Die Modelle verfügen über eine generative Fähigkeit und waren der Beginn der generativen KI.

Generative KI basiert also auf LLMs.

LLMs werden auf Terabytes an Textdaten aus dem Internet trainiert. Diese Modelle sind in der Lage, komplexe Antworten auf hoher Ebene auf Eingabeaufforderungen in der menschlichen Sprache zu liefern. Im Fall von ChatGPT war ein Durchbruch die Entdeckung, dass mit etwas zusätzlichem Training die LLMs verwendet werden können, um beeindruckende textbasierte Ergebnisse zu erzielen.

Generativer KI ermöglicht die Erstellung langspielbarer High-Fidelity-Musik aus Textbeschreibungen und zusätzlichen Toneingabebedingungen und kann Blogs erstellen, Anzeigentexte schreiben, neue Inhalte basierend auf Texteingaben erstellen und ist in der Lage, den Stil und Ton von Textinhalten zusammenzufassen und zu ändern. Generative KI bezieht sich auf eine Klasse von KI-Algorithmen die ohne direkten menschlichen Eingriff neue Inhalte wie Texte, Bilder oder Videos generieren können und komplexe Probleme zu lösen und sich wiederholende Aufgaben zu automatisieren.

Da sich diese Technologie ständig weiterentwickelt, bietet sie eine vielversprechende Lösung für das uralte Dilemma, alltägliche, sich wiederholende Aufgaben mit hochwertigerer kognitiver Arbeit unter einen Hut zu bringen.

Einer der bedeutendsten Vorteile der generativen KI ist ihre Effizienz bei der Bewältigung sich wiederholender und alltäglicher Aufgaben.

Die Geschwindigkeit und Reichweite der Entwicklung der generativen KI ist absolut beispiellos. Es wurde mit der Einführung der Druckerpresse verglichen.

Generative KI hat einen erheblichen Einfluss auf Wissensarbeit, Marketing und Vertrieb, sein volles Potenzial muss jedoch noch ausgeschöpft werden. Darüber hinaus verspricht die Technologie Effizienzsteigerungen bei der Softwareentwicklung.

Die Beschleunigung des Einsatzes großer Sprachmodelle (LLMs) ist ein aufkommender Markttrend für generative KI. ChatGPT erreichte 100 Millionen Nutzer schneller als jede andere App. GPT-3 wurde ursprünglich mit 45 Terabyte Daten trainiert.

Das Ziel der generativen KI-gestützten Suche scheint darin zu bestehen, das genaueste Einzelergebnis und nicht eine Liste der Top-Websites bereitzustellen. Die generative KI-Suche ist sowohl für PPC als auch für SEO von entscheidender Bedeutung.

Anwendungen von Generative KI

ChatGPT ist ein öffentlich verfügbarer webbasierter Chatbot und eine API-Schnittstelle, die von OpenAI erstellt wurde. Es stellt eine Verbindung zu einem großen Sprachmodell (LLM) namens GPT (Generative Pre-Trained Transformer) her.

ChatGPT sagt über sich selbst: "Ich wurde trainiert, um menschenänliche Konversation zu führen und Antworten auf Fragen zu geben, die auf natürliche Sprachen gestellt werden. Ich würde entwickelt, um als digitaler Assistent, Informationsquelle und Unterhaltungsmedium zu dienen."

ChatGPT demonstrierte die Fähigkeit, Text basierend auf Eingabeaufforderungen in natürlicher Sprache zu generieren. Mithilfe des Konzepts von Basismodellen können große Mengen vorab trainierter Daten mit einem geringen zusätzlichen Aufwand an Abstimmung und Eingabeaufforderung genutzt werden. Beim Tuning werden den Daten Beschriftungen hinzugefügt. Aufforderungen überbrücken die Lücke zwischen Training und Absicht.

ChatGPT hat das Internet mit der Chat-Vervollständigungsfunktion revolutioniert. Man kann damit eine Menge tun: eine E-Mail oder ein anderes Schreiben verfassen, Fragen zu einer Reihe von Dokumenten beantworten, Konversationsagenten erstellen, einer Software eine Schnittstelle in natürlicher Sprache geben, Nachhilfe in verschiedenen Fächern geben, Sprachen übersetzen und so weiter.

Eine CLI-Chat-App kann mit Node.js oder React erstellt werden. Während es mehr als 50 Jahre dauerte, bis gedruckte Bücher in ganz Europa allgemein verfügbar waren, erreichte ChatGPT in nur zwei Monaten 100 Millionen Nutzer.

ChatGPT wird mithilfe großer Datenmengen aus dem Internet trainiert. LLMs unterscheiden sich jedoch in folgenden Punkten von Internet-Suchmaschinen: Keine laufenden täglichen Webcrawler und Updates.

ChatGPT verwendet eine Art Feinabstimmung namens Reinforcement Learning from Human Feedback (RLHF).

Der Durchbruch, der BERT- und ChatGPT-basierte Modelle ermöglichte, heißt Transformers und wurde in einem Artikel aus dem Jahr 2017 mit dem Titel "Aufmerksamkeit ist alles, was Sie brauchen" vorgestellt. Es wurde als eine Möglichkeit vorgestellt, eine maschinelle Übersetzung zu erstellen, aber eine viel schnellere parallele Ausführung zu ermöglichen. Außerdem wurde ein neues Konzept namens "Selbstaufmerksamkeit": "Und Computer zu programmieren war so faszinierend. Man erschafft sein kleines Universum, und dann tut es, was man der IT sagt." ( Vinton Cerf, US-amerikanischer Informatik-Ingenieur) eingeführt, um lange Sprachsequenzen besser zu verstehen. Es stellt Verbindungen zwischen verschiedenen Teilen der Sequenz her. Es stellt Verbindungen zwischen verschiedenen Teilen der Sequenz her. Es gibt Nutzungsszenarien, die einige von Menschen geleistete Arbeit reduzieren oder ersetzen können. Diese beinhalten: Texte verarbeiten und zusammenfassen, von Menschen erstellte Inhalte filtern, Erstellen fortgeschrittener Chatbots-Codes, generieren gestalteter Dokumente (z. B. Lebensläufe, Vorschläge, E-Mails).

GPT umfasst einige der größten Modelle, die jemals erstellt wurden. Nach dem Modelltraining erfolgt eine weitere Feinabstimmung, um die generierte Reaktion zu verbessern. Das T in GPT steht für Transformer. Transformer sind künstliche neuronale Netze mit einer besonderen Architektur. Sie wird von grossen Sprachmodellen wie ChatGPT verwendet, wurde in 2017 von Forschern bei Google entwickelt und führte damals zu Spitzenleistungen bei der Sprachübersetzung. Interessanterweise ist dieses Modell in leicht abgewandelter Form aber eigentlich schon 1991 von dem KI-Pioneer Jürgen Schmidhuber erfunden worden. Vor dem aktuellen Durchbruch von der Transformer-Architektur wurden für Aufgaben wie zum Beispiel das Klassifizieren von Bildern oder der Sprachübersetzung jeweils spezifische, für eine bestimmte Aufgabe entwickelte Netzwerk-Architekturen verwendet.

Man kann einem Sprachmodell wie ChatGPT zum Beispiel mehrere kurze Texte geben und jeweils angeben, ob die Texte grundsätzlich eine positive oder negative Grundstimmung haben. Dann legt man dem Modell einen Text vor, den er noch nicht gesehen hat, und es wird anhand der Beispiele, die Sie dem Modell gegeben haben, ziemlich sicher lernen und beurteilen, ob der neue Text positiv oder negativ ist. Alles, was diese Modelle erhalten, ist eine kurze Texteingabe. Die Transformer nutzen diese wenigen Informationen, um ihr Ergebnis zu optimieren.

DALL-E kann Bilder erzeugen.

GPT-Neo ist ein vielversprechendes Open-Source-LLM.

GPT-3, das Modell hinter ChatGPT, hat 175 Milliarden Parameter.

Amazon setzt sich seit langem für KI und ML ein und unterstützt über 100.000 Kunden, darunter auch Hersteller, die sich jetzt mit generativer KI beschäftigen. Generative KI kann die Fertigung optimieren.

In der Software-Engineering wird KI immer häufiger eingesetzt und kann Entwicklern dabei helfen, die Generierung und Umgestaltung von Code und die Dokumentation um 20 bis 50% zu beschleunigen (McKinsey-Bericht).

Unter generativem Coding versteht man den Einsatz generativer KI zur Unterstützung der Softwareentwicklung. Es war eine der ersten Anwendungen der generativen KI-Technologie, die kommerzialisiert wurde.

Generative KI, GPT-Engineer, ChatGPT und große Sprachmodelle (LLMs) wie GitHub Copilot und andere KI-Codegenerierungstools verändern die Softwareentwicklungspraktiken und die Produktivität.

LISP wurde zu einer häufig verwendete Sprache für die Programmierung von KI.

Code Llama (Code Large Language Model Meta AI) ist ein KI-System, das Code auf Englisch generiert und erklärt. Ähnlich wie GitHub Copilot und Amazon CodeWhisperer unterstützt Code Llama Entwickler beim Codieren und Debuggen in verschiedenen Sprachen wie Python, Java und C++. Es bestehen jedoch Bedenken, da KI-Codierungstools Sicherheitslücken schaffen oder geistiges Eigentum verletzen können. Entwickler nutzen immer häufiger kontinuierliche Tests mit generativen KI.

Llama steht für Large Language Model Meta AI. Es handelt sich hierbei um ein auto-regressives großes Sprachmodell, das eine optimierte Transformerarchitektur verwendet. Es ist das zweite Foundational Model aus dem Hause Meta AI, das im Jahr 2023 erschienen ist. Schon die erste Version von Llama, die Ende Februar 2023 veröffentlicht wurde, war quelloffen. Llama 2 ist open-source. Das eröffnet viele neue Möglichkeiten, denn so können verschiedenste Anwendungen auf der Llama-Architektur aufgebaut werden. Llama 2 gibt es in verschiedenen Größen mit 7, 13, 34 oder 70 Milliarden Parametern. Trainiert wurde auf 2 Trillionen Token mit über einer Millionen menschlicher Annotationen.

Ein künstliches neuronales Netz (KNN - Artificial Neural Network ANN) ist ein System aus Hardware und/oder Software, das der Funktionsweise von Neuronen im menschlichen Gehirn nachgebildet ist. KNNs sind eine Vielzahl von Deep-Learning-Technologien, die unter den Begriff der KI fallen.

Ob aktuelle oder zukünftige KI-Systeme bewusst sein könnten, ist ein Thema von wissenschaftlichem Interesse und zunehmender öffentlicher Besorgnis. Aus prominente wissenschaftliche Bewusstseinstheorien, darunter die Theorie der wiederkehrenden Verarbeitung, Theorien höherer Ordnung, prädiktive Verarbeitung und die Theorie des Aufmerksamkeitsschemas kann man "Indikatoreigenschaften" des Bewusstseins ableiten, die ermöglichen, KI-Systeme auf diese Eigenschaften hin zu bewerten. Diese Indikatoreigenschaften legen nahe, dass derzeit keine KI-Systeme bewusst sind, deutet aber auch darauf hin, dass es keine offensichtlichen technischen Hindernisse für den Aufbau von KI-Systemen gibt, die diese Indikatoren erfüllen.

Natural Language Processing (NLP) ist ein Zweig der Informatik - und insbesondere ein Bereich der KI. Es stützt sich vornehmlich auf uns und unsere Realität, und vor allem auf unser wichtigstes Kommunikationsmittel: Die Sprache. Anschließend verknüpft es sie mit Statistik, Machine und Deep Learning. Durch die Kombination von Linguistik und Informatik, ist es das Ziel von NLP, Sprachstrukturen- und -richtlinien zu entschlüsseln. Damit will es Modelle erstellen, die wichtige Details aus Texten und Sprache verstehen, aufschlüsseln und trennen können. Es geht also darum, Computer in die Lage zu versetzen, Texte und gesprochene Worte in ähnlicher Weise wie Menschen zu verstehen.

Kontextuelle KI ermöglicht es Unternehmen, das wahre Potenzial der KI auszuschöpfen, indem sie Sprachmodelle in ihren internen Wissensdatenbanken und Datenquellen verankern. Kontextuelle Sprachmodelle (Contextual Language Models - CLMs) erstellen Antworten, die auf die Daten und das institutionelle Wissen eines Unternehmens zugeschnitten sind. Dies führt zu höherer Genauigkeit, besserer Compliance, weniger Halluzinationen und der Möglichkeit, Antworten auf Quelldokumente zurückzuführen.

Könnte auch sein, dass Verhaltensweisen auftauchen, die für die Informatik völlig neu sind. ETH-Forscher haben eine neue Programmiersprache namens LMQL (Language Model Query Language) entwickelt. Durch die Kombination von natürlicher Sprache und Programmiersprache können gezieltere Anfragen an grosse Sprachmodelle, wie ChatGPT, gestellt werden. Die neue Programmiersprache ermöglicht es, den Nutzenden Sicherheitseinschränkungen zu formulieren, um unerwünschte Ergebnisse möglichst zu vermeiden.

Azure AI Speech ist ein Speech-Dienst von Microsoft und bietet mit einer Speech-Ressource Funktionen für die Spracherkennung und Sprachsynthese. Sie können Sprache mit hoher Genauigkeit in Text transkribieren, Text in natürlich klingende Sprache konvertieren, gesprochene Audiodaten übersetzen und bei Konversationen die Sprechererkennung verwenden.

Der genetische Algorithmus (GA) ist die Methode zur Lösung von Problemen, indem Beispiele natürlicher Prozesse, insbesondere natürlicher Evolution, wie Mutation, Vererbung, Selektion und Kreuzung herangezogen werden. GA sind von Darwins Evolutionstheorie inspiriert. GA wurde in den 1970er Jahren von John Holland an der University of Michigan in den USA erfunden und nicht nur von ihm und seinen Studenten, sondern auch von seinen Kollegen weiterentwickelt.

Im Bereich der Cybersicherheit hat das Katz-und-Maus-Spiel zwischen Hackern und Verteidigern mit dem Aufkommen der KI-Technologie eine neue Wendung genommen. Hacker, immer auf der Suche nach effizienteren und effektiveren Möglichkeiten, die Sicherheit zu durchbrechen, haben die Macht der KI genutzt, um Passwörter auf beispiellose Weise zu knacken.

Es gibt fünf Strategien, die Hacker neulich anwenden:

- Intelligente Brute-Force-Angriffe

- Passwortvorhersagemodelle

- KI-gestützte Wörterbuchangriffe

- Auf maschinellem Lernen (ML) basierende Angriffe

- Hybride Angriffe

Heutzutage ist Cybersicherheit eine milliardenschwere Branche mit einer ständig wachsenden Liste von Unternehmen, die sich auf die Entwicklung und Implementierung von Cybersicherheitslösungen spezialisiert haben. Von Firewalls bis hin zu Verschlüsselung sind diese Lösungen darauf ausgelegt, sowohl Einzelpersonen als auch Unternehmen vor der sich ständig weiterentwickelnden Bedrohung durch Cyberkriminalität zu schützen. Einer der größten Trends in der Cybersicherheit ist die Integration von künstlicher Intelligenz (KI) und maschinellem Lernen (ML). Diese Technologien haben das Potenzial, unsere Herangehensweise an Cybersicherheit zu revolutionieren, indem sie es uns ermöglichen, riesige Datenmengen zu analysieren und Bedrohungen in Echtzeit zu identifizieren. Mithilfe von Algorithmen für ML können beispielsweise Anomalien im Netzwerkverkehr erkannt, potenzielle Angriffe identifiziert und darauf reagiert werden, bevor sie erheblichen Schaden anrichten können. KI und ML können auch zur Analyse großer Datenmengen eingesetzt werden und dabei helfen, Muster und Trends zu erkennen, die auf einen Cyberangriff hinweisen können.

Neulich wird statt Artificial Intelligence immer häufiger der Begriff Augmented Intelligence verwendet.

Künstliche Intelligenz der Dinge (AIoT) ist die Kombination von Technologien der KI und dem Internet der Dinge (IoT).

Anwendungen von KI

Es gibt Nutzungsszenarien von KI, die einige von Menschen geleistete Arbeit reduzieren oder ersetzen können:

- Texte verarbeiten und zusammenfassen

- Von Menschen erstellte Inhalte filtern

- Erstellen fortgeschrittener Chatbots

- Code schreiben

- Kundendienst und Support

- Generieren gestalteter Dokumente (z. B. Lebensläufe, Vorschläge, E-Mails)

Medizin

KI wird eingesetzt in der Prävention (z.B. Smarte Wearables), bei Screening (Erkennen von Auffälligkeiten auf einem Röntgen-Bild, Erkennen von Parkinson durch die Analyse von Augenetzhaut Bilder), bei der Diagnostik, bei der Therapie (Roboterassistierte Operationen), bei der Nachsorge, und um neue Medikamente bereitzustellen. Mithilfe von KI können auch virtuelle Assistenten geschaffen werden, die Patienten informieren und ihnen helfen können.

Finanzen und Bankwesen

KI wird derzeit eingesetzt, um Betrug zu erkennen, Risiken zu kontrollieren und Anlageberatung anzubieten. Mithilfe von KI-gestützten Algorithmen können beispielsweise Finanzdaten untersucht und Trends erkannt werden, die auf Betrug hinweisen können. KI kann auch zur Entwicklung von Handelstechniken eingesetzt werden, die die Entscheidungsfindung von Anlegern unterstützen.

Bildungswesen

KI verändert die Bildungslandschaft rasant: sie hat das Potenzial, das Lernen zu personalisieren, die Bewertung zu verbessern und Aufgaben zu automatisieren, sodass Lehrer mehr Zeit haben, sich auf kreativere und strategischere Arbeit zu konzentrieren. KI wird also eingesetzt bei personalisiertes Lernen, bei der Intelligenten Content-Erstellung, bei Intelligente Bewertungssysteme, bei virtuellen Klassenzimmer und virtuelle Realität, bei Intelligente Systeme zur Studierendenunterstützung und bei ethische Überlegungen und Herausforderungen.

Logistik

Dateneingabe und Kundenservice sind zwei Beispiele für Aufgaben, die mithilfe von KI automatisiert werden. KI kann bei der Schaffung neuer Waren und Dienstleistungen eingesetzt werden. Mithilfe von KI lassen sich beispielsweise selbstfahrende Autos konstruieren oder Vorschläge für Kunden personalisieren.

Unterhaltung

KI wird genutzt, um neue Formen der Unterhaltung zu entwickeln, darunterChatbots und Virtual-Reality-Spiele. KI kann auch genutzt werden, um die Qualität aktuell verfügbarer Unterhaltung zu verbessern, indem beispielsweise überzeugendere spektakuläre Effekte oder interessante Handlungsstränge erzeugt werden.

Sport und Fitness

KI wird genutzt, um individuellere Fitnesserlebnisse und neue Sporttrainingstools anzubieten. Beispielsweise können Trainer, die KI einsetzen, den Spielern sofortiges Feedback geben, um ihnen zu besseren Leistungen zu verhelfen. Mit KI können auch Virtual-Reality-Spiele erstellt werden, die zum Training oder zum Spaß gespielt werden können.

Weitere aktuelle oder geplante Einsätze von KI

- Industrie 4.0

- Software-Codierung, Dokumentation und Testautomatisierung

- Kognitive Modellierung und logische Programmierung

- Generierung von Text, Bilder und Videos im Internet

- Erkennung und Verarbeitung von Bilder

- Erkennung von natürlicher Sprache und deren Übersetzung

- Maschinelles Lernen/Mustererkennung

- Expertensysteme, Frage-Antwort Systeme, Chatbots

- Schach-Computer programmieren

- Web-Suchmaschinen (z.B. Google, MS Bing)

- Assistiertes Fahren und Navigation

- Künstliche Neuronale Netze und Deep Learning

- Intelligente Roboter

- Bildung

- Wissensdarstellung

- Wissenschaft und Forschung (z.B. CERN)

- Raumfahrt (z.B. Curiosity Mars Rover)

- Computerspiel

- Computer Vision

- Zukünftige Smartphones

Maschinelles Lernen (ML - Deap Learning)

ML ist ein Teilbereich der KI und bezeichnet das Lernen von IT-Systeme, um Daten und Muster zu verbessern, anstatt explizit programmiert zu werden.

ML kann in das Gesundheitswesen, die Industrie 4.0 und das autonome Fahren (selbstfahrende Fahrzeuge) eingesetzt werden.

Aza Raskin, ein bekannter Designer von Computer-Benutzeroberflächen, hatte 2013 die Idee, mit Big-Data-Methoden Tiersprachen zu analysieren.